据 meiguo.com 于 2026 年 1 月 6 日收到的消息 ‣ 在2026年CES展会上,英伟达首席执行官黄仁勋宣布,原计划在下半年发布的革命性AI芯片Rubin已经在第一季度实现全面投产,提前两个季度完成量产。此举在半导体行业掀起强烈反响。

从去年下半年开始量产的Blackwell,到第三季度推出的Blackwell Ultra,英伟达的产品迭代已快到让竞争对手难以跟上。Rubin的推出标志着英伟达将新一代芯片的研发周期压缩到不足12个月,进一步巩固其在AI芯片领域的领先优势。

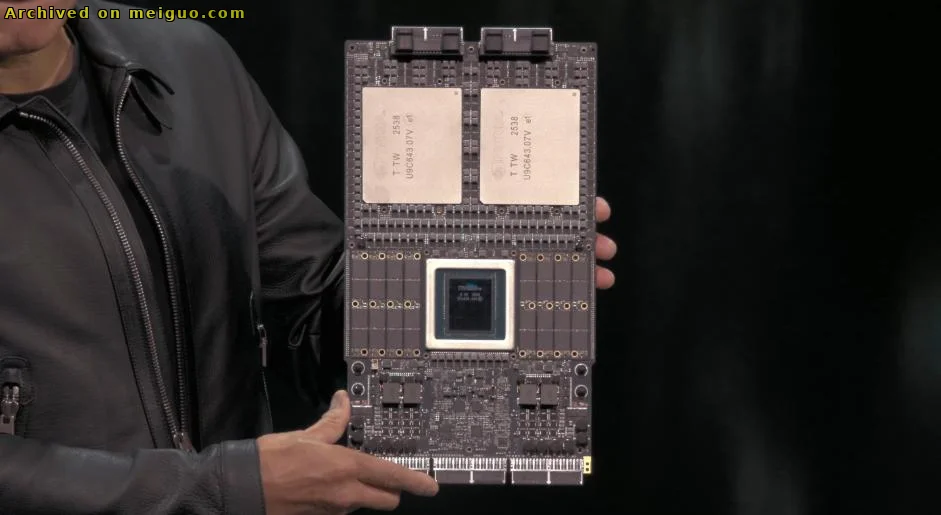

英伟达的Rubin超级芯片

Rubin平台一次性发布了六款芯片,形成完整生态。核心Rubin GPU内部集成了3360亿个晶体管;配套的Vera CPU拥有88个Olympus核心,晶体管数量达到2270亿。完整系统还包括NVLINK 6互连交换机、用于网络的CX9和BF4芯片,以及用于硅光子学的Spectrum‑X 102.4T CPO。全部芯片均采用先进制程,并已准备好大规模量产。

英伟达首席财务官此前曾预测Rubin将在2026年下半年进入量产阶段,但公司现已宣布在第一季度实现全面投产。按照此时间表,预计下半年客户即可收到实际订单。Rubin将与持续供货的Blackwell Ultra一起,成为英伟达新的收入引擎。

在性能方面,Rubin GPU的FP4精度推理算力达到50 PFLOPS,比Blackwell GB200提升约5倍;训练性能达35 PFLOPS,提升约3.5倍。这种跨代跃升将显著降低大模型训练的时间和能耗成本。

与此同时,英伟达计划于2026年2月中旬在中国市场交付基于Hopper架构的H200芯片,FP16精度算力约2 PFLOPS。对比之下,Rubin在FP4精度下的推理性能约为H200的25倍,显示出明显的代际差距。

英伟达H200

Rubin的研发工作早在三年前同步启动,期间整合了HBM4显存、全新架构设计和更强的AI计算能力。该芯片配备22 TB/s的显存带宽,单卡搭载288 GB显存,并采用第三代Transformer引擎,专为大语言模型的训练和推理优化。

OpenAI已确认将采用Rubin架构,云服务巨头AWS、Google Cloud、微软Azure、甲骨文云等亦在预订相应实例。新兴云服务商如CoreWeave、Lambda、Nebius和Nscale也已加入抢购行列,预计下半年基于Rubin的云实例将快速涌现。

英伟达之所以能够实现如此高速的产品交付,得益于多年在CUDA生态和AI芯片设计上的深厚积累、强大的供应链管理能力以及对市场需求的精准判断。竞争对手虽然已推出对标Hopper的产品,但英伟达已在出货Blackwell Ultra;当对手准备研发新一代芯片时,Rubin已进入量产阶段,形成了明显的技术领先。

尽管提前投产伴随巨大的研发和资本投入,且市场判断若失误风险高企,但英伟达对AI算力需求的长期增长保持强烈信心。从Hopper到Blackwell再到Rubin,英伟达保持着每年甚至更短周期推出新架构的节奏,以速度和技术双重优势持续压制竞争。

Rubin的提前量产再次彰显了英伟达在AI芯片领域的绝对统治地位。2026年有望成为AI基础设施的关键一年,Rubin的实际交付表现和客户反馈将深刻影响整个AI产业的演进。

综合自网络信息